· Michael Stöckler · Insights · 10 min read

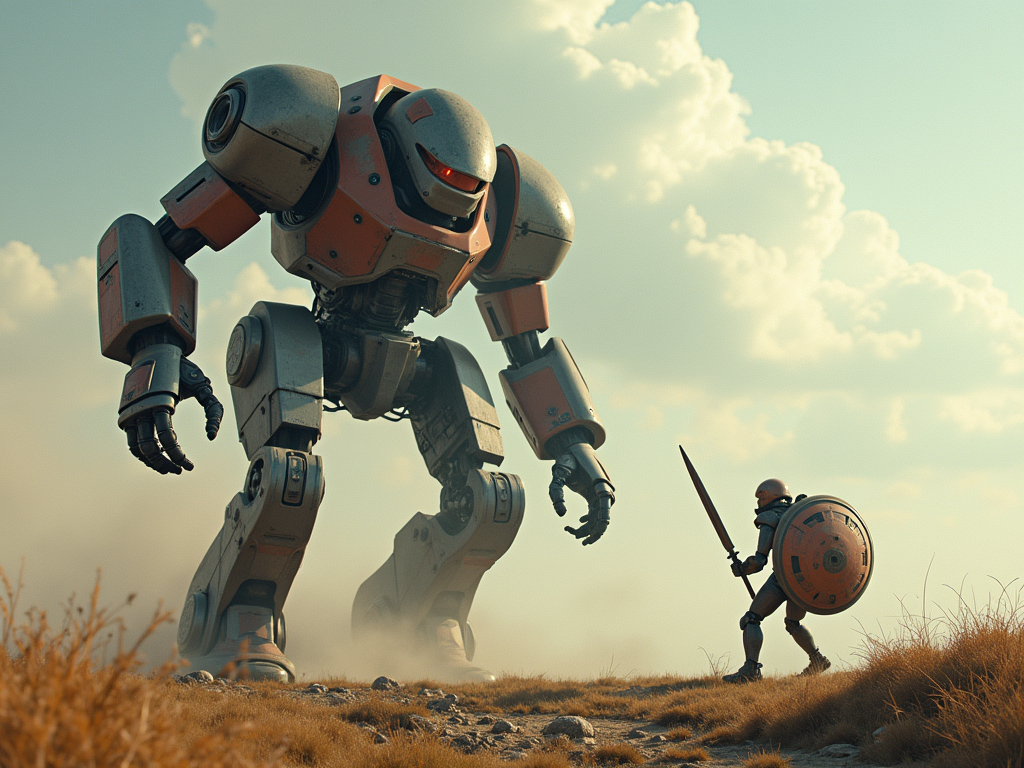

Große Sprachmodelle revolutionieren die Kommunikation

Sprachmodelle revolutionieren die Art, wie wir mit Computern interagieren. Am Beispiel eines KI-Maklerassistenten zeigt dieser Artikel, wie moderne Large Language Models (LLMs) komplexe Aufgaben selbstständig bewältigen können. Von den technischen Grundlagen über praktische Anwendungen bis hin zu Herausforderungen bei der Implementation erfahren Entscheider, was beim Einsatz dieser zukunftsweisenden Technologie zu beachten ist.

Einordnung

Die Art und Weise, wie wir mit Computern kommunizieren, erlebt aktuell einen fundamentalen Wandel. Während wir uns jahrzehntelang an die Denkweise von Maschinen anpassen mussten, können wir heute in natürlicher Sprache mit ihnen interagieren. Diese Revolution wird durch große Sprachmodelle (Large Language Models, LLMs) wie ChatGPT vorangetrieben, die unsere Sprache nicht nur verarbeiten, sondern auch verstehen und sinnvoll darauf reagieren können.

Der Weg zu dieser Entwicklung war lang. Noch vor wenigen Jahren basierten Chatbots auf starren Regeln und vordefinierten Antworten. Sie konnten nur auf exakt programmierte Fragen reagieren und waren bei unerwarteten Eingaben schnell überfordert. Die neuen Sprachmodelle hingegen können flexibel auf verschiedenste Anfragen reagieren, Texte verfassen, Analysen durchführen und sogar kreative Aufgaben bewältigen.

In diesem Artikel beleuchten wir, wie diese transformative Technologie funktioniert und welche Möglichkeiten sie für Unternehmen eröffnet. Wir erklären die Evolution der Sprachverarbeitung, die technischen Grundlagen moderner Sprachmodelle und zeigen anhand konkreter Beispiele, wie Unternehmen diese Technologie gewinnbringend einsetzen können. Dabei gehen wir auch auf wichtige Aspekte wie Datenschutz und Integration ein, die für eine erfolgreiche Implementierung entscheidend sind.

Die Evolution der Sprachverarbeitung

Die Geschichte der maschinellen Sprachverarbeitung gleicht einer technologischen Evolution. In den 1960er Jahren erschuf Joseph Weizenbaum mit ELIZA den ersten Chatbot der Welt. ELIZA funktionierte nach einem einfachen Prinzip: Wenn ein Nutzer “Ich bin traurig” schrieb, suchte das System nach dem Muster “Ich bin” und antwortete mit einer vorprogrammierten Frage wie “Warum sind Sie traurig?”. Diese regelbasierte Kommunikation war revolutionär, aber stark limitiert.

Der lange Weg zum Sprachverständnis

In den folgenden Jahrzehnten versuchten Forscher, Computern echtes Sprachverständnis beizubringen. Ein wichtiger Schritt waren statistische Modelle, die Wahrscheinlichkeiten für Wortfolgen berechneten. Stellen Sie sich vor, der Computer lernt wie ein Kind durch Beobachtung: Nach “Der Hund” folgt häufig “bellt”, selten “miaut”. Diese Modelle konnten zwar Muster erkennen, verstanden aber nicht wirklich die Bedeutung.

Die Transformer-Revolution

2017 führte Google die Transformer-Architektur ein – ein Wendepunkt in der KI-Geschichte. Das Besondere an Transformern ist ihre Fähigkeit zur “Selbstaufmerksamkeit” (Self-Attention). Ein praktisches Beispiel: Nehmen wir den Satz “Die Bank am Flussufer war nass, aber die Bank in der Innenstadt hatte bereits geschlossen.” Ein Transformer versteht durch den Kontext, dass das erste “Bank” eine Sitzgelegenheit ist und das zweite ein Geldinstitut.

Self-Attention ist ein revolutionärer Mechanismus in der künstlichen Intelligenz, der die Art und Weise, wie Modelle Sequenzen von Daten verarbeiten, grundlegend verändert hat.

Grundprinzip

Der Mechanismus ermöglicht es einem KI-Modell, die Bedeutung und Beziehungen zwischen verschiedenen Elementen einer Sequenz dynamisch abzuwägen. Stellen Sie sich einen Satz vor: “Die Katze, die vom Hund gejagt wurde, rannte den Baum hinauf.” Self-Attention ermöglicht es dem Modell, die direkte Verbindung zwischen “Katze” und “rannte” zu erkennen, auch wenn diese Wörter weit voneinander entfernt sind.

🔬 Funktionsweise

Der Self-Attention-Mechanismus arbeitet in mehreren Schritten:

Verarbeitung:

Für jedes Element in einer Sequenz werden drei Vektoren erzeugt:

- Abfrage (Query)

- Schlüssel (Key)

- und Wert (Value)

Diese Vektoren entstehen durch mathematische Transformationen der Eingabedaten.

Aufmerksamkeitsberechnung:

Das System berechnet Aufmerksamkeitswerte zwischen allen Elementen der Sequenz durch Scaled Dot-Product Attention (skalierte Aufmerksamkeitsberechnung mittels Skalarprodukt). Diese Werte bestimmen, wie stark jedes Element die anderen Elemente beeinflusst.

Vorteile

Parallele Verarbeitung: Anders als traditionelle Methoden kann Self-Attention alle Berechnungen gleichzeitig durchführen, was zu erheblichen Geschwindigkeitsvorteilen führt.

Flexible Kontexterfassung: Der Mechanismus kann Beziehungen zwischen Elementen unabhängig von ihrer Position in der Sequenz erfassen.

Verbesserte Langzeitabhängigkeiten: Self-Attention überwindet die Beschränkungen älterer Modelle bei der Verarbeitung langer Sequenzen, da es direkte Verbindungen zwischen allen Elementen herstellt.

Praktische Bedeutung

Self-Attention ist heute ein fundamentaler Baustein moderner KI-Systeme und wird in führenden Sprachmodellen eingesetzt. Der Mechanismus ermöglicht es Modellen, Texte besser zu verstehen, präzisere Übersetzungen zu erstellen und kontextbezogene Antworten zu generieren.

Das Geheimnis moderner Sprachmodelle

Moderne LLMs wie GPT basieren auf einer erweiterten Transformer-Architektur. Sie werden in zwei Phasen entwickelt:

- Pre-Training: Das Modell liest Milliarden von Texten und lernt dabei Sprache in ihrer gesamten Komplexität. Wie ein Student, der jahrelang Bücher liest und Zusammenhänge versteht.

- Fine-Tuning: Das Modell wird für spezifische Aufgaben optimiert, ähnlich einer Spezialisierung nach dem Studium.

Der Quantensprung durch Skalierung

Der beeindruckende Fortschritt der letzten Jahre basiert auf drei Faktoren:

- Größere Modelle: GPT-4 hat über 1 Billion Parameter – vergleichbar mit den Synapsen im menschlichen Gehirn (circa 100 Billionen)

- Bessere Trainingsdaten: Sorgfältig kuratierte Datensätze aus dem Internet, Büchern und wissenschaftlichen Texten

- Fortgeschrittene Trainingsmethoden: Neue Techniken wie “Few-Shot Learning” ermöglichen es den Modellen, aus wenigen Beispielen zu lernen

Praktische Bedeutung

Diese technologische Evolution ermöglicht völlig neue Anwendungen. Ein modernes Sprachmodell kann nicht nur Kundenanfragen beantworten, sondern auch:

- Komplexe Texte zusammenfassen

- Technische Dokumentationen in verständliche Sprache übersetzen

- Kreative Texte für das Marketing erstellen

- Programmcode analysieren und erklären

Die Fähigkeiten dieser Systeme übertreffen bei weitem die einfache Mustererkennung früherer Generationen. Sie verstehen Kontext, können logische Schlüsse ziehen und sogar kreativ sein – Fähigkeiten, die bis vor kurzem als exklusiv menschlich galten.

Die Funktionsweise von LLMs

Der Begriff LLM steht für “Large Language Model” (Großes Sprachmodell) und beschreibt eine neue Generation von KI-Systemen, die auf die Verarbeitung natürlicher Sprache spezialisiert sind. Die Bezeichnung “Large” bezieht sich dabei auf zwei wesentliche Aspekte:

Umfang der Trainingsdaten Diese Modelle werden mit enormen Textmengen trainiert - oft mehrere Billionen Wörter aus Büchern, Artikeln und Webseiten. Wie unser KI-Maklerassistent zeigt, ermöglicht dies dem System, kontextbezogene und (im Rahmen des aktuell technisch möglichen) sachlich korrekte Texte zu verschiedensten Themen zu generieren.

Modellgröße Die Modelle selbst bestehen aus Milliarden oder sogar Billionen von Parametern, die während des Trainings optimiert werden. Diese Komplexität ermöglicht es ihnen, sprachliche Nuancen zu verstehen und natürlich klingende Texte zu produzieren.

Der Begriff “Language Model” beschreibt die Kernfunktion: Die Systeme modellieren Sprache mathematisch und können dadurch Zusammenhänge zwischen Wörtern und deren Bedeutungen erfassen. Dies ermöglicht es ihnen kohärente und kontextbezogene Texte zu generieren.

Das Grundprinzip des Sprachverstehens

Um zu verstehen, wie LLMs Sprache verarbeiten, stellen Sie sich einen sehr belesenen Assistenten vor, der Milliarden von Textseiten gelesen hat. Dieser Assistent hat dabei nicht nur Wörter auswendig gelernt, sondern komplexe Muster und Zusammenhänge erkannt. Das Besondere: Er versteht Sprache auf verschiedenen Ebenen – von der Grammatik bis zur kulturellen Bedeutung.

Tokenisierung: Die Grundbausteine der Sprachverarbeitung

LLMs zerlegen zunächst jeden Text in sogenannte Tokens. Ein Token kann ein Wort, ein Teilwort oder auch ein Satzzeichen sein. Beispiel: Der Satz “Künstliche Intelligenz” wird etwa zu: [“Künst”, “liche”, “Intel”, “ligenz”] Diese Zerlegung ermöglicht es dem Modell, auch mit unbekannten Wörtern umzugehen, indem es sie aus bekannten Teilstücken zusammensetzt.

Kontextverständnis durch Attention

Der revolutionäre Aspekt moderner LLMs ist ihr Kontextverständnis. In dem Satz “Der Chip war defekt, also musste ich ihn austauschen” versteht das System, dass “Chip” sich auf ein elektronisches Bauteil bezieht. Im Satz “Der Chip war lecker, also kaufte ich noch einen” erkennt es die Bedeutung als Snack. Dies geschieht durch die “Attention-Mechanismen”, die jedes Wort in Beziehung zu allen anderen Wörtern setzen.

Das “Denken” der Modelle

LLMs arbeiten mit Wahrscheinlichkeiten. Bei der Eingabe “Die Hauptstadt von Deutschland ist…” berechnet das Modell die Wahrscheinlichkeit für jedes mögliche nächste Wort. “Berlin” erhält dabei eine sehr hohe Wahrscheinlichkeit, “Hamburg” eine niedrigere, “Franzbrötchen” praktisch keine. Diese Berechnungen geschehen über viele Ebenen (Layer) hinweg, wobei jede Ebene verschiedene Aspekte der Sprache analysiert.

Grenzen des “Verstehens”

Wichtig ist: LLMs verstehen nicht wie Menschen. Sie haben:

- Kein echtes Weltwissen, sondern statistische Korrelationen

- Keine Erfahrungen mit der physischen Welt

- Keine eigenen Überzeugungen oder Emotionen

Praktisches Beispiel: Textgenerierung

Nehmen wir an, ein LLM soll einen Geschäftsbrief verfassen. Es:

- Analysiert die Anforderungen und den gewünschten Stil

- Identifiziert typische Formulierungen aus Geschäftsbriefen

- Generiert passende Textbausteine

- Verknüpft diese zu einem kohärenten Text

- Prüft die Logik und Angemessenheit

Die Rolle des Trainings

Das Training eines LLMs ähnelt dem Lernen eines Musikinstruments:

- Erst kommt das Grundlagentraining (Pre-Training) mit enormen Textmengen

- Dann die Feinabstimmung (Fine-Tuning) für spezifische Aufgaben

- Schließlich das “Üben” durch Feedback und Korrektur

Diese komplexe Technologie ermöglicht es LLMs, menschenähnliche Texte zu produzieren, Fragen zu beantworten und sogar kreative Aufgaben zu lösen – immer basierend auf den Mustern, die sie in ihren Trainingsdaten erkannt haben.

Praktische Anwendungen von Sprachmodellen

Kundenservice und Support

Eine sehr wichtige Anwendung von Sprachmodellen findet sich im Kundenservice. Moderne KI-Assistenten können rund um die Uhr Kundenanfragen beantworten, komplexe Probleme verstehen und personalisierte Lösungen anbieten.

Ein Beispiel: Bei Salesforce nutzt der Einstein AI-Assistant die Fähigkeit, Kundenabsichten zu verstehen und durchsucht automatisch verschiedene Wissensquellen wie Wissensdatenbanken, CRM-Systeme und Webinhalte, um präzise Antworten zu generieren.

Textgenerierung und Content-Erstellung

Sprachmodelle haben sich als leistungsstarke Werkzeuge für die Erstellung hochwertiger Inhalte etabliert. Sie können:

- Marketing-Texte und Produktbeschreibungen erstellen

- Technische Dokumentationen in verständliche Sprache übersetzen

- Berichte und Analysen zusammenfassen Die Besonderheit liegt in der Fähigkeit, den Schreibstil an verschiedene Zielgruppen und Formate anzupassen.

Übersetzung und Lokalisierung

Im Bereich der internationalen Geschäftskommunikation ermöglichen LLMs eine schnelle und präzise Übersetzung von Websites, Software und Marketing-Materialien. Die Modelle berücksichtigen dabei nicht nur die reine Übersetzung, sondern auch kulturelle Nuancen und branchenspezifische Terminologie.

Dokumentenanalyse und Rechtswesen

Im juristischen Bereich revolutionieren Sprachmodelle die Vertragsanalyse und Rechtsrecherche. Sie können:

- Komplexe Rechtsdokumente analysieren und zusammenfassen

- Relevante Präzedenzfälle identifizieren

- Vertragliche Verpflichtungen und Klauseln interpretieren

Finanzwesen und Banking

Im Finanzsektor unterstützen LLMs bei der:

- Erstellung detaillierter Finanzberichte

- Durchführung von Marktanalysen

- Bearbeitung von Routineanfragen im Banking

- Erkennung potenziell betrügerischer Aktivitäten

Personalwesen und Recruiting

Im HR-Bereich optimieren Sprachmodelle den gesamten Einstellungsprozess:

- Automatisierte Vorauswahl von Bewerbungen

- Unterstützung beim Onboarding neuer Mitarbeiter

- Beantwortung von Mitarbeiterfragen zu Richtlinien und Prozessen

E-Commerce und Produktbeschreibungen

Im Online-Handel generieren LLMs automatisch:

- Individuelle und detaillierte Produktbeschreibungen

- Personalisierte Produktempfehlungen

- Kundenspezifische Marketing-Materialien

Fallstudie: Der KI-Maklerassistent

Ein anschauliches Beispiel für den praktischen Einsatz von LLMs ist unser Showcase eines KI-Maklerassistenten. Dieses innovative Tool demonstriert die Fähigkeiten moderner Sprachmodelle zur automatisierten Analyse und Textgenerierung.

Funktionsweise und Besonderheiten

Der Assistent arbeitet nach einem einfachen, aber effektiven Prinzip:

- Der Nutzer gibt lediglich eine Adresse ein (z.B. “Böttgerstraße Hamburg”)

- “Versteht” ob es sich dabei um eine Straße, Nachbarschaft oder eine Stadt handelt

- Analysiert daraufhin automatisch die Umgebung

- Erstellt eine detaillierte, natürlich klingende Umgebungsanalyse

Mehrwert für die Immobilienbranche

Die generierte Analyse zeichnet sich durch mehrere Qualitäten aus:

- Strukturierte Darstellung wichtiger Standortfaktoren

- Berücksichtigung verschiedener Aspekte wie Verkehrsanbindung, Infrastruktur und Freizeitmöglichkeiten

- Professionelle, sachliche Formulierung

- Automatische Anpassung an lokale Besonderheiten

Praktische Vorteile

Diese Automatisierung bietet erhebliche Vorteile:

- Zeitersparnis bei der Erstellung von Exposés

- Konsistente Qualität der Umgebungsbeschreibungen

- Skalierbarkeit für beliebig viele Objekte

- Reduzierung manueller Recherchearbeit

Diese Fallstudie zeigt exemplarisch, wie LLMs komplexe Aufgaben automatisieren und dabei qualitativ hochwertige Ergebnisse liefern können, die früher zeitaufwändige manuelle Arbeit erforderten.

Die praktische Umsetzung erfordert dabei stets eine sorgfältige Balance zwischen Automatisierung und menschlicher Überprüfung. Besonders bei kritischen Geschäftsprozessen bleibt der Mensch als finale Kontrollinstanz unerlässlich.

Herausforderungen und Lösungen

Die Integration von LLMs in Unternehmensprozesse erfordert eine sorgfältige Balance zwischen Innovation und Kontrolle. Der KI-Maklerassistent demonstriert exemplarisch, wie wichtig eine transparente Kennzeichnung und rechtliche Absicherung bei KI-generierten Inhalten ist.

Datenschutz und Compliance

Die Integration von LLMs erfordert besondere Aufmerksamkeit im Bereich Datenschutz. Unternehmen müssen die EU-KI-Verordnung und DSGVO strikt einhalten sowie klare Prozesse für die Datenverarbeitung etablieren. Wie am Beispiel des KI-Maklerassistenten ersichtlich wird, gehört dazu auch der explizite Hinweis auf KI-generierte Inhalte und mögliche Ungenauigkeiten.

Qualitätssicherung und Kontrolle

Die Qualitätskontrolle basiert auf einem mehrstufigen System:

- Automatisierte Prüfmechanismen für Standardfehler

- Menschliche Überprüfung kritischer Inhalte

- Kontinuierliche Verbesserung durch Feedback

Die technische Integration erfordert eine durchdachte Infrastruktur. Moderne LLM-Anwendungen wie der KI-Maklerassistent benötigen eine robuste Cloud-Infrastruktur und zuverlässige API-Schnittstellen zu bestehenden Systemen.

Mitarbeiterakzeptanz und Schulung

Der nachhaltige Erfolg von LLM-Implementierungen hängt maßgeblich von der Mitarbeiterakzeptanz ab. Entscheidend sind:

- Praxisorientierte Schulungsprogramme

- Intuitive Benutzeroberflächen

- Verlässliche Support-Strukturen

Das Kostenmanagement muss verschiedene Faktoren berücksichtigen. Neben API-Kosten fallen Ausgaben für Infrastruktur, Personal und Schulungen an. Die Investition rentiert sich besonders bei spezifischen Anwendungsfällen wie zum Beispiel der automatisierten Umgebungsanalyse für Immobilien.

Diese ausgewogene Herangehensweise ermöglicht es Unternehmen, die Vorteile von LLMs optimal zu nutzen und dabei Risiken zu minimieren. Der Schlüssel zum Erfolg liegt in der Balance zwischen technologischer Innovation und kontrollierter Implementierung.

Fazit und Zukunftsausblick

Die Entwicklung von Sprachmodellen markiert einen Wendepunkt in der Unternehmenskommunikation. Wie unser KI-Maklerassistent beispielhaft zeigt, können LLMs bereits heute komplexe Aufgaben wie die Erstellung von Umgebungsanalysen selbstständig und in hoher Qualität bewältigen.

Die Technologie entwickelt sich dabei mit beeindruckender Geschwindigkeit weiter. Neue Modelle werden präziser, verstehen Kontext besser und können noch natürlichere Texte generieren. Für Unternehmen bedeutet dies enorme Chancen zur Prozessoptimierung und Effizienzsteigerung.

Entscheidend für den erfolgreichen Einsatz bleibt jedoch der verantwortungsvolle Umgang mit der Technologie. Transparenz gegenüber Nutzern, wie zum Beispiel durch den klaren Hinweis auf KI-generierte Inhalte praktiziert, wird dabei zum Standard werden müssen.

Die Zukunft liegt in der intelligenten Kombination von menschlicher Expertise und KI-Unterstützung. Nicht der Ersatz menschlicher Arbeit, sondern deren Ergänzung und Optimierung wird den nachhaltigen Mehrwert dieser Technologie ausmachen.