· Michael Stöckler · Insight · 5 min read

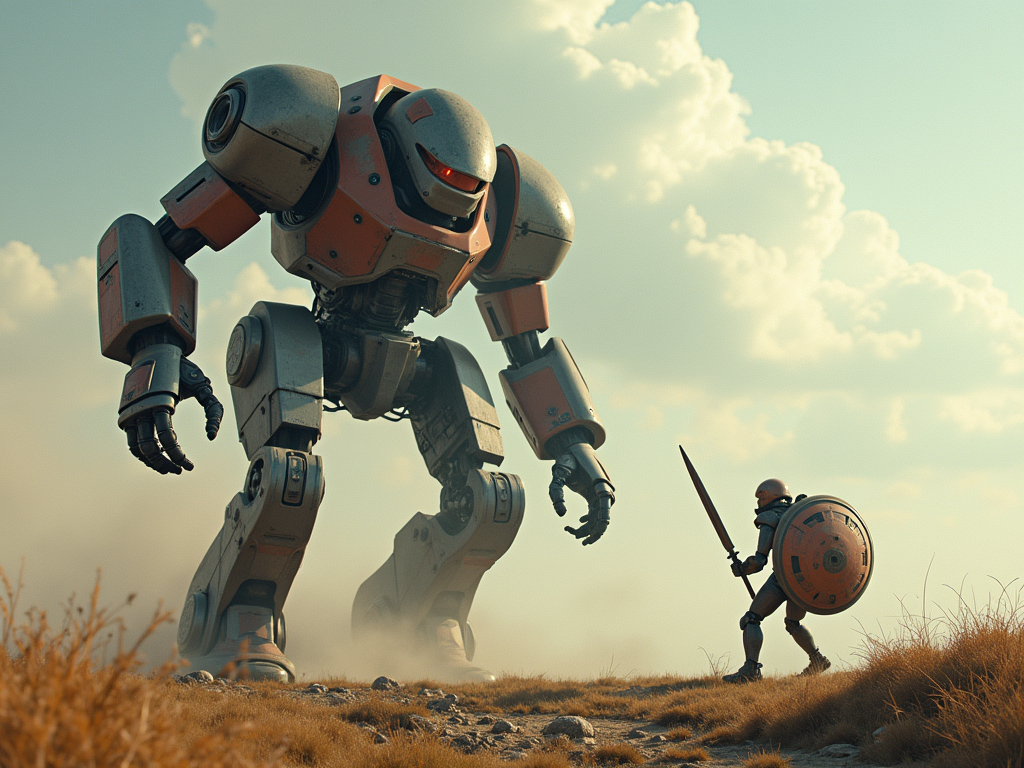

Die KI-Revolution im Bewegtbild: Wie moderne KI-Modelle Videos aus Text erschaffen

Wie Sora, Veo und Co. die Videoproduktion revolutionieren und aus einfachen Texten atemberaubende Filme erschaffen.

Die letzten Wochen haben die Welt der künstlichen Intelligenz erneut in Staunen versetzt. Mit der Veröffentlichung von drei bahnbrechenden Videogenerierungsmodellen – OpenAI’s Sora, Google’s Veo und Tencent’s HunyuanVideo – wurde ein neues Kapitel in der Geschichte der KI-gestützten Contentproduktion aufgeschlagen. Während OpenAI seinen Dienst für zahlende Nutzer zugänglich macht, setzt Google auf professionelle Anwendungen, und Tencent wählt einen Open-Source-Ansatz. Doch wie funktioniert diese faszinierende Technologie eigentlich?

Von Einzelbildern zu fließenden Bewegungen

Die Faszination der KI-Videogenerierung basiert auf einer komplexen Verschmelzung verschiedener Technologien. Stellen Sie sich vor, Sie würden einen Animationsfilm erstellen – traditionell zeichnet man dafür viele einzelne Bilder, die nacheinander abgespielt eine flüssige Bewegung ergeben. KI-Videomodelle arbeiten nach einem ähnlichen, wenn auch weitaus komplexeren Prinzip.

Der Grundbaustein: Diffusion Den Kern bildet ein Prozess namens Diffusion. Technisch betrachtet beginnt das System mit zufälligem Rauschen – vergleichbar mit dem Schnee auf einem alten Fernseher – und verfeinert dieses schrittweise zu einem klaren Bild. Bei Videos muss dieser Prozess jedoch nicht nur für ein einzelnes Bild funktionieren, sondern für eine ganze Sequenz von Bildern, die zudem perfekt aufeinander abgestimmt sein müssen.

Die große Herausforderung: Zeitliche Konsistenz

Was Videogenerierung so viel komplexer macht als die Erstellung von Einzelbildern, ist die Notwendigkeit, Konsistenz über die Zeit zu gewährleisten. Stellen Sie sich vor, Sie beschreiben einer KI eine Person mit rotem Pullover, die durch einen Park spaziert. Das System muss nun sicherstellen, dass der Pullover in jedem Frame rot bleibt, dass die Person sich natürlich bewegt und dass der Hintergrund sich entsprechend der Bewegung logisch verändert.

Bewegung verstehen und erzeugen Um diese Herausforderung zu meistern, nutzen moderne Videomodelle ausgeklügelte Systeme zur Bewegungsanalyse und -vorhersage:

- Sie berechnen, wie sich Objekte von Frame zu Frame bewegen sollten

- Sie erfassen die Tiefe und räumliche Anordnung von Objekten

- Sie koordinieren komplexe Bewegungsmuster über längere Sequenzen

Künstliche Intelligenz als Filmemacher

Die neuen Modelle von OpenAI, Google und Tencent gehen dabei weit über simple Bewegtbildgenerierung hinaus. Sie verstehen filmische Konzepte wie Kameraführung, Bildkomposition und sogar verschiedene cineastische Stile. Google’s Veo beispielsweise bietet spezielle Kontrollfunktionen für Filmemacher, die es ermöglichen, die generierten Videos nach professionellen Standards zu bearbeiten.

Von der Textbeschreibung zum fertigen Video Der Prozess beginnt mit einer textlichen Beschreibung dessen, was im Video zu sehen sein soll. Das System analysiert diese Beschreibung und zerlegt sie in verschiedene Aspekte:

- Hauptakteure und ihre Eigenschaften

- Umgebung und Atmosphäre

- Handlung und Bewegungsabläufe

- Stilistische Elemente

Showcase Kling

Das unten gezeigte Video wurde zum Beispiel mit dem Videomodell von Kling AI erzeugt. Als Ausgangspunkt dienten hier ein Standbild und der folgende Prompt:

A cinematic aerial shot. Showing a Christmas tree in Hamburg on a lake.Covering an entire day, starting in the morning an ending at night.Snow starts falling and Santa Claus is crossing the sky with his sleigh.Einerseits sind die Ergebnisse durchaus beindruckend. Das Video stellt wie gefordert die Veränderung über den ganzen Tag dar. Es schneit, zumindest ein wenig, und am Ende ist sogar kurz ein Weihnachtsmann zu sehen, wobei hier die Darstellung des Weihnachtsmann sicherlich zu wünschen übrig lässt. Von dem geforderten Schlitten ist leider nichts zu sehen. Hierbei ist allerdings anzumerken, dass ein besserer Prompt oder die Generierung von zwei Videos dieses Problem sicherlich reduzieren würde.

Technische Innovation im Hintergrund

Die Leistungsfähigkeit dieser neuen Generation von Videomodellen basiert auf mehreren technischen Durchbrüchen. Anders als frühere Systeme nutzen sie hochentwickelte neuronale Netzwerke, die speziell für die Verarbeitung von Bewegtbildern optimiert wurden.

Effiziente Datenverarbeitung Eine der größten Herausforderungen liegt in der schieren Menge an Daten, die verarbeitet werden müssen. Ein 20-sekündiges Video in HD-Qualität besteht aus Hunderten von Einzelbildern, die alle perfekt aufeinander abgestimmt sein müssen. Die neuen Modelle verwenden daher innovative Techniken zur Datenkompression und -verarbeitung:

- Latente Diffusionsmodelle arbeiten mit komprimierten Versionen der Videos

- Spezielle Aufmerksamkeitsmechanismen fokussieren sich auf relevante Bildbereiche

- Optimierte Speichernutzung ermöglicht längere Videosequenzen

Sicherheit und Verantwortung

Mit der zunehmenden Verfügbarkeit dieser Technologie stellen sich auch wichtige Fragen bezüglich ihrer verantwortungsvollen Nutzung. OpenAI hat bei Sora von Anfang an Sicherheitsmechanismen implementiert:

- Jedes generierte Video enthält digitale Wasserzeichen

- C2PA-Metadaten ermöglichen die Nachverfolgung der Herkunft

- Inhaltliche Beschränkungen sollen Missbrauch verhindern

Ausblick in die Zukunft

Die aktuelle Generation von Videogenerierungsmodellen ist erst der Anfang. Zukünftige Entwicklungen werden voraussichtlich noch längere und qualitativ hochwertigere Videos ermöglichen. Die unterschiedlichen Ansätze der großen Tech-Unternehmen – von OpenAIs kommerziellem Service bis zu Tencents Open-Source-Strategie – werden dabei zu einem gesunden Wettbewerb und schnellen Innovationen führen.

Potenzielle Anwendungen Die Einsatzmöglichkeiten dieser Technologie sind vielfältig:

- Filmproduktion und visuelle Effekte

- Bildungsinhalte und Tutorials

- Marketing und Werbung

- Persönliche Kreativprojekte

Fazit

Die neuen KI-Videogenerierungsmodelle markieren einen bedeutenden Fortschritt in der künstlichen Intelligenz. Sie kombinieren komplexe technische Innovationen mit benutzerfreundlichen Schnittstellen und eröffnen damit neue Möglichkeiten für kreative Ausdrucksformen. Während die technischen Grundlagen auf jahrelanger Forschung und Entwicklung basieren, macht erst die Kombination verschiedener Technologien die beeindruckenden Ergebnisse möglich, die wir heute sehen.

Die Herausforderung für die Zukunft wird darin bestehen, diese Technologie verantwortungsvoll weiterzuentwickeln und dabei sowohl die kreativen Möglichkeiten als auch die ethischen Aspekte im Blick zu behalten. Mit den aktuellen Entwicklungen von OpenAI, Google und Tencent wurde jedenfalls ein wichtiger Grundstein für die Zukunft der automatisierten Videoproduktion gelegt.